L’intelligence artificielle bouleverse notre rapport au monde. Ses promesses sont immenses : gain de temps, personnalisation, efficacité accrue. Pourtant, cette révolution technologique ne s’accompagne pas toujours d’une adhésion spontanée du public. Au contraire, une frange croissante de consommateurs exprime un besoin de réassurance. Face à l’abondance d’informations, aux dérives potentielles et à la perte de repères, la confiance devient une denrée rare.

C’est dans ce contexte que le rapport « Controlling the Chaos », publié par Digitas et Vox Media, prend tout son sens. Cette étude, menée en décembre 2024 sur un panel représentatif de 2 000 adultes américains, analyse la façon dont les individus perçoivent l’IA, et ce qu’ils attendent des marques pour renouer avec un sentiment de stabilité. Le principal enseignement ? Si l’innovation attire, elle doit être guidée par des valeurs claires : humanité, transparence, éthique.

Ce que les consommateurs attendent vraiment des marques

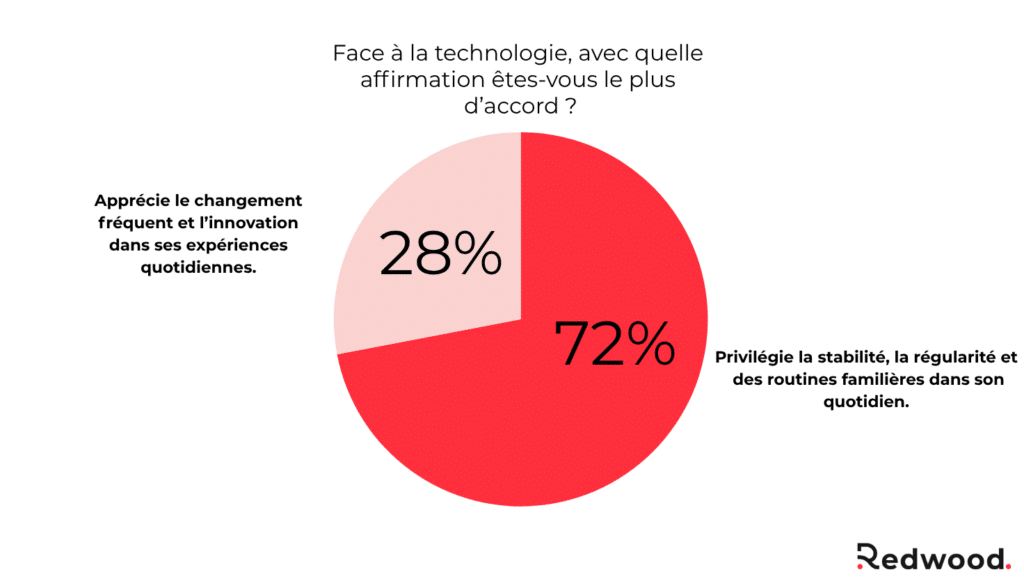

L’étude révèle une tension entre une grande curiosité pour les technologies d’IA (avec plus de 1,2 million de recherches mensuelles) et une forte aspiration à la stabilité. Près de 83 % des sondés disent privilégier des produits et services stables, fiables et prévisibles. Ce besoin de repères se traduit par cinq grandes attentes vis-à-vis des marques.

La première est la transparence. Les consommateurs ne rejettent pas l’IA en soi, mais veulent savoir quand et comment elle est utilisée. 89 % souhaitent que les entreprises soient plus ouvertes sur leurs pratiques, et 58 % exigent que l’usage de l’IA soit clairement signalé dans les contenus. Une démarche comparable à celle de l’étiquetage alimentaire : dire ce qui est « artificiel » pour mieux comprendre ce que l’on consomme.

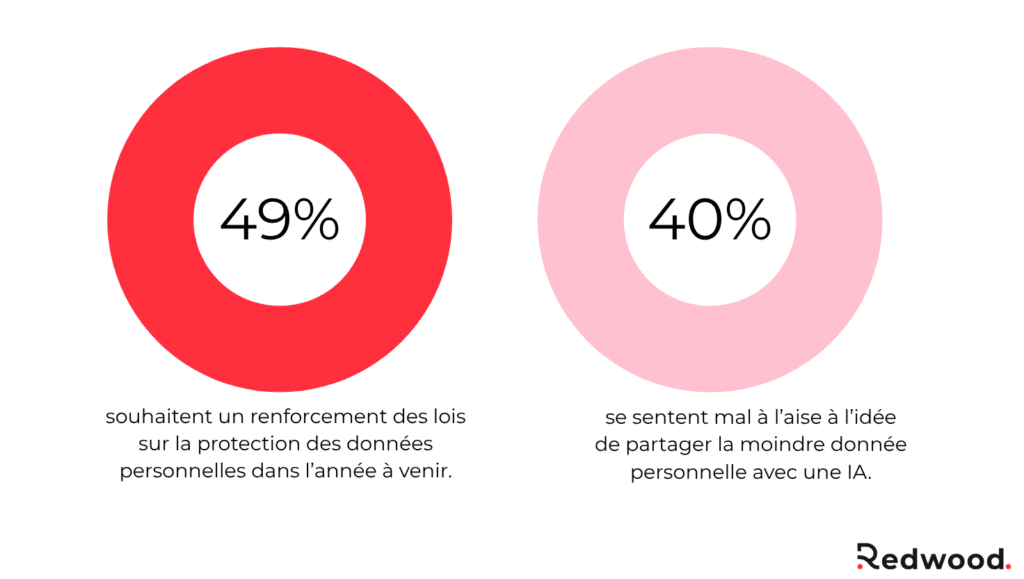

La deuxième attente concerne la protection des données personnelles. Alors que 40 % des consommateurs se disent mal à l’aise à l’idée de partager des informations avec une IA, 49 % désirent un renforcement des lois sur la vie privée. Les marques doivent donc montrer qu’elles méritent cette confiance : en sécurisant les données, en étant claires sur leur usage, et en apportant une valeur tangible en retour.

Troisième pilier : l’éthique. L’idée d’une IA toute-puissante et incontrôlée inquiète. 90 % des sondés souhaitent que l’humain garde la main sur les décisions prises par les systèmes automatisés. Plus de 80 % demandent même une régulation gouvernementale pour encadrer les usages de l’IA. Les marques ont un rôle à jouer dans la définition de ces garde-fous.

Par ailleurs, la personnalisation reste plébiscitée, à condition qu’elle soit utile et non intrusive. Les consommateurs veulent des expériences adaptées, mais refusent une hyper-surveillance algorithmique. Ils attendent des interactions fluides, intelligentes, mais aussi respectueuses de leur anonymat.

Enfin, les marques doivent se montrer coopératives et utiles. L’IA est bien acceptée lorsqu’elle simplifie la vie quotidienne : organiser un voyage, faire ses achats, recevoir des conseils personnalisés. L’enjeu est de démontrer une vraie utilité, au-delà du gadget ou de la démonstration technologique.

Cinq leviers concrets pour inspirer la confiance

Les marques ont tout à gagner à adopter une posture proactive. Voici cinq stratégies que Redwood recommande pour instaurer une relation de confiance durable avec vos publics.

1. Clarifier vos usages de l’IA

Clarifier vos usages de l’IA, c’est avant tout faire preuve de pédagogie et de transparence. Cela implique de répondre à des questions simples, mais essentielles :

- À quel moment l’IA intervient-elle dans l’expérience client ?

- Pour quelles tâches est-elle utilisée ? (création de contenu, recommandation, automatisation, service client…)

- Quel type de modèle ou de technologie est mobilisé ?

- Quelle part de contrôle est laissée à l’humain ?

Cette clarification doit être explicite et accessible. Il ne s’agit pas de noyer l’utilisateur sous un jargon technique, mais de lui offrir une compréhension claire et rassurante. À l’image d’un étiquetage alimentaire, il faut dire ce qui est « naturel », ce qui est « artificiel », et pourquoi cela a été choisi. 58 % des consommateurs attendent d’ailleurs un étiquetage systématique des contenus générés par l’IA.

En pratique, cela peut passer par :

- Des mentions visibles sur vos interfaces ou contenus : “Ce texte a été coécrit avec une IA”.

- Des FAQ pédagogiques sur vos pratiques IA.

- Des pages de politique d’usage claires, voire des manifestes d’innovation responsable.

Cette transparence est aussi un facteur différenciant : elle permet de poser les bases d’un contrat de confiance entre la marque et ses publics. Elle montre que l’IA n’est pas utilisée pour manipuler ou remplacer l’humain, mais pour améliorer l’expérience, en toute conscience.

Enfin, clarifier vos usages de l’IA, c’est aussi vous aligner en interne. Cela signifie que vos équipes – marketing, produit, data, juridique – partagent une même compréhension des finalités et des limites de ces outils. Car une IA bien utilisée est une IA bien comprise.

2. Instaurer une gouvernance éthique de l’IA

Utiliser l’IA de manière responsable ne relève pas seulement d’un choix technologique, mais d’un véritable engagement éthique. Face aux attentes croissantes des consommateurs en matière de régulation et de respect des valeurs humaines, les marques doivent structurer leur usage de l’intelligence artificielle autour de règles claires, visibles et durables.

Une gouvernance éthique de l’IA repose d’abord sur la mise en place d’un cadre interne. Il ne s’agit pas uniquement de rédiger une charte pour cocher une case, mais de concevoir un dispositif vivant et opérationnel qui guide les décisions au quotidien :

- Quelles sont les finalités acceptables ou interdites pour vos systèmes d’IA ?

- Comment identifiez-vous les biais algorithmiques ?

- Quels garde-fous garantissent que l’humain garde toujours le contrôle ?

- Qui est responsable des dérives éventuelles ? Et selon quelles procédures de contrôle ?

💡 Cela peut prendre plusieurs formes :

- Une charte IA alignée avec vos valeurs d’entreprise (éthique, inclusion, transparence),

- Un comité de pilotage interdisciplinaire (marketing, tech, juridique, RH…) chargé de valider et suivre les projets IA,

- Des audits réguliers des modèles et des données utilisées (notamment pour détecter des biais ou des dérives discriminatoires),

- Une documentation claire sur les décisions prises par les systèmes automatisés, avec possibilité d’explication ou de recours humain.

Dans l’étude Controlling the Chaos, 90 % des répondants affirment qu’un humain doit pouvoir reprendre la main à tout moment. C’est une attente forte qui doit se traduire concrètement dans vos process : l’IA peut assister, mais elle ne doit jamais décider seule sur des sujets à fort impact (contenus sensibles, modération, santé, finances…).

Enfin, la gouvernance éthique ne doit pas être perçue comme un frein à l’innovation, mais comme un accélérateur de légitimité. En assumant publiquement une démarche rigoureuse et responsable, vous gagnez la confiance de vos utilisateurs, de vos partenaires et de vos équipes. Vous devenez une marque référente, non parce que vous utilisez l’IA, mais parce que vous le faites bien.

3. Mettre la sécurité au centre de vos dispositifs

La puissance de l’IA va de pair avec de nouveaux risques, parfois sous-estimés par les marques. Détournements de données, hallucinations, deepfakes, fuites d’informations sensibles, attaques sur les modèles eux-mêmes… : le développement rapide des technologies génère des vulnérabilités inédites, et donc un impératif accru de sécurité.

Dans un climat de méfiance généralisée, vous ne pouvez pas demander la confiance sans garantir la protection. La sécurité doit donc être pensée comme un pilier fondamental de votre stratégie IA, et non comme une contrainte technique accessoire.

Cela commence par une hygiène numérique renforcée :

- Limitation des accès aux systèmes sensibles,

- Chiffrement des données à tous les niveaux (transit, stockage, traitement),

- Authentification forte et surveillance des usages internes,

- Mises à jour systématiques des outils IA et des bibliothèques open source utilisées.

Mais cela va bien au-delà. Les outils basés sur l’IA génèrent, croisent, interprètent une grande quantité d’informations parfois très personnelles. Il est donc indispensable de :

- Limiter les jeux de données à ce qui est strictement nécessaire,

- Anonymiser les données utilisées pour l’entraînement ou les analyses,

- Documenter les traitements automatisés, notamment s’ils touchent à des profils ou des comportements clients,

- Et surtout, informer clairement l’utilisateur sur ce qui est fait de ses données.

La certification est ici un levier fort. RGPD, ISO/IEC 27001, labels sectoriels… En vous appuyant sur des standards reconnus, vous démontrez votre engagement sur des bases objectives et auditées. Vous rassurez vos clients, mais aussi vos partenaires, investisseurs et collaborateurs.

Dans un contexte où les cyberattaques ciblant les systèmes IA se multiplient, investir dans la sécurité, c’est préserver votre réputation, mais aussi votre capacité d’innovation. Une faille mal maîtrisée peut détruire en quelques heures des mois de travail et de communication.

Sécuriser vos dispositifs IA, c’est donc protéger la confiance, à la fois dans la technologie, dans votre marque, et dans la relation que vous construisez avec vos publics.

4. Personnaliser avec modération

L’IA offre un potentiel immense en matière de personnalisation : contenus dynamiques, recommandations en temps réel, messages adaptés aux préférences individuelles… Lorsqu’elle est bien utilisée, la personnalisation améliore l’expérience client, renforce l’engagement et optimise les performances marketing.

Mais cette capacité peut aussi susciter de la gêne, voire du rejet. Une personnalisation trop poussée, trop opaque ou trop intrusive donne le sentiment d’être observé, profilé, manipulé. Dans l’étude Controlling the Chaos, près d’un consommateur sur deux se dit mal à l’aise à l’idée de partager ses données avec une IA. L’attente est claire : plus de pertinence, oui — mais dans le respect de la vie privée.

C’est pourquoi il faut trouver le bon équilibre : personnaliser sans surveiller, adapter sans envahir, recommander sans imposer.

Pour cela, quelques principes clés :

- Collectez uniquement ce qui est nécessaire à la personnalisation. Inutile d’accumuler des données si elles ne servent pas à créer une vraie valeur.

- Soyez transparent sur les critères de recommandation ou de segmentation : dites pourquoi un contenu est proposé, comment il est sélectionné.

- Laissez toujours à l’utilisateur un choix : désactiver la personnalisation, ajuster ses préférences, accéder à ses données ou demander leur suppression.

- Privilégiez une personnalisation utile, contextuelle, bienveillante : ne cherchez pas à tout savoir, mais à mieux servir.

L’enjeu est de repositionner la personnalisation comme un service, et non comme une surveillance algorithmique. Elle doit améliorer l’expérience utilisateur sans générer d’inconfort. C’est en donnant à vos publics le contrôle sur leurs données et leur parcours que vous bâtissez une relation saine et durable.

En 2025, la personnalisation ne se mesure plus seulement à la précision d’une recommandation. Elle se mesure à sa pertinence perçue, à sa valeur ajoutée réelle, et à la confiance qu’elle inspire.

5. Créer une boucle de dialogue avec vos clients

L’intelligence artificielle transforme la manière dont les marques interagissent avec leurs publics. Mais cette transformation ne doit pas signifier la fin de l’écoute. Au contraire : plus les technologies s’interposent dans la relation, plus celle-ci doit être nourrie par un dialogue actif, continu et sincère.

Instaurer une boucle de retour entre vos systèmes IA et vos utilisateurs, c’est mettre l’humain au centre. C’est reconnaître que la confiance ne se décrète pas — elle se construit, au fil des échanges. Et que toute innovation, pour être acceptée, doit pouvoir être questionnée, testée, ajustée.

👉 Concrètement, cela suppose :

- D’intégrer des dispositifs de feedback simples et accessibles à chaque point de contact (formulaires de satisfaction, notations, commentaires libres, signalement de contenus inappropriés…),

- D’expliquer comment les retours sont pris en compte (et à quelle fréquence),

- D’itérer vos systèmes IA en fonction des usages réels, et non des seules prévisions internes,

- De répondre aux interrogations des clients : sur le fonctionnement des recommandations, les limites des outils, ou les décisions prises par des systèmes automatisés.

💬 Cette démarche de co-construction crée un climat de reconnaissance mutuelle. Vous ne traitez plus vos utilisateurs comme de simples destinataires passifs, mais comme des partenaires de votre innovation. Vous les impliquez, vous leur donnez une voix, et vous montrez que leur expérience réelle a plus de valeur que n’importe quel KPI.

Dans un monde de plus en plus automatisé, c’est cette capacité à dialoguer qui distingue les marques responsables des autres. L’IA ne doit pas couper le lien entre l’entreprise et ses clients — elle doit l’enrichir. À condition de l’écouter.

Faites de la confiance votre levier de croissance

En 2025, la confiance devient la clé d’une relation durable entre marques et consommateurs. L’IA peut être un formidable levier, à condition d’être utilisée avec humanité, cohérence et responsabilité.

Redwood vous accompagne

L’agence Redwood vous aide à :

- Créer des contenus clairs et transparents,

- Bâtir une stratégie de communication responsable,

- Renforcer la confiance grâce à une posture pédagogique et engageante.

Contactez-nous pour transformer ces enjeux en opportunités de croissance.